1. Breve história do Clima

O clima da Terra varia naturalmente, devido a mutações em sua órbita em torno do Sol, além de fatores internos e externos, e, no passado, sua temperatura já esteve mais alta que a atual.

Com efeito, neste último milhão de anos o Planeta Terra passou por nove glaciações.

Contando que cada glaciação dura cerca de 100 mil anos segundo registros geológicos e é interrompida por períodos quentes denominados interglaciais de 10 mil anos aproximadamente, nove glaciações perfazem um total de 900 mil anos.

Esse total representa, portanto, 90% desse último milhão de anos, quando as temperaturas da Terra foram inferiores às atuais.

Ou seja, o clima da Terra tem sido, em quase sua totalidade, mais frio que o atual!

Em 2009, os paleoclimatologistas Louise C. Sime e colegas conseguiram, por meio dos testemunhos de gelo [ice cores] da Estação de Vostok, Antártica, reconstruir qualitativamente o clima nos últimos 420 mil anos, tendo concluído que as temperaturas dos três últimos interglaciais, os de 130 mil, 240 mil e 320 mil anos atrás, foram entre 6°C e 10°C superiores às de hoje.

Isto é, o clima da Terra já esteve bem mais quente que o atual, e o homo sapiens, cuja existência é estimada em 150 mil anos, já sobreviveu ao pico de duas eras glaciais e a um interglacial, sem dispor das tecnologias que possuímos hoje.

Neste interglacial [Holoceno] no qual estamos vivendo, as temperaturas já estiveram cerca de 4°C mais altas que às atuais há sete/oito mil anos, de acordo com o artigo de Shaun Marcott e colegas em 2013, período conhecido como o Ótimo do Holoceno.

Posteriormente, ocorreram períodos quentes como Minoano [1.500 aC], Romano [400 aC – 300 dC] e o Medieval [900 dC – 1300 dC].

Nesse último, de muita riqueza e abundância de recursos e alimentos, floresceram as artes [Romanesco, Gótico e Árabe] e se iniciaram a construção das grandes catedrais europeias.

|

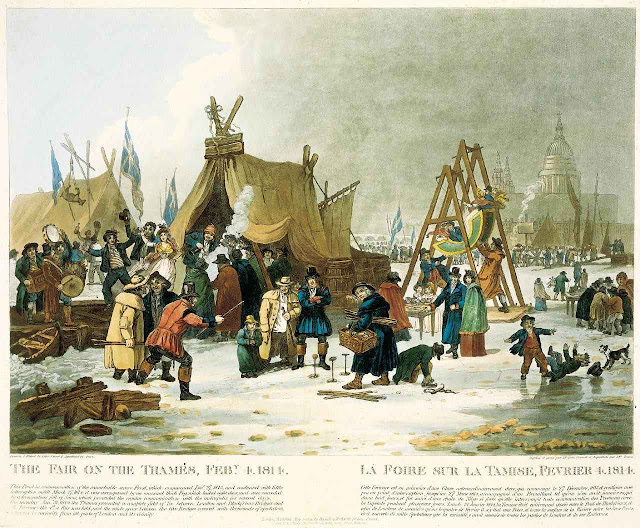

| Feira sobre o Tamisa na Pequena Idade de Gelo |

De cerca de 1300 dC até o início do século XX [ca. 1915], o clima esfriou, período conhecido com Pequena Idade do Gelo [PIG], que foi desastroso para a Humanidade.

Doenças e pestes – como a Peste Negra [Yersinia pestis] que, estima-se, tenha matado mais de 70 milhões de pessoas somente na Europa — grassaram pelos continentes, além de constantes frustrações de safras agrícolas, devido aos invernos mais longos, fizeram com que a população ficasse faminta.

Tal situação gerou grandes distúrbios sociais, dos quais um excelente exemplo é a Revolução Francesa de 1789 que, na sua esteira, desencadeou uma série de revoluções, como as independências dos países latino-americanos no início do século XIX.

Depois de 1915, as temperaturas começaram a aumentar novamente.

O aquecimento global entre 1916-1945, em que a concentração e as emissões de dióxido de carbono [CO2] eram baixas, foi natural e causado pela maior atividade solar já registrada nos últimos 400 anos, além de uma possível redução da cobertura de nuvens.

No Hemisfério Norte, as observações indicam que as temperaturas da década dos anos 1930 continuam sendo os maiores valores registrados nos últimos 130 anos.

No entanto, entre 1946-1975 ocorreu um ligeiro resfriamento global, caracterizado por invernos mais rigorosos que os atuais.

Naquela oportunidade, alguns climatologistas e a mídia propalavam que “uma nova era glacial era iminente”.

A partir de 1976, os oceanos, particularmente o Pacífico, começaram a se aquecer novamente, possivelmente devido à redução de 5% na cobertura de nuvens, demonstrada pelo Projeto Internacional de Climatologia de Nuvens por Satélite [ISCCP, sigla em Inglês], que permitiu a entrada de maior fluxo de radiação solar no Planeta.

|

| Oscilações da atividade solar segundo a NASA |

Simultaneamente, eventos El Niño fortes — que sabidamente liberam muito calor para a atmosfera — foram mais frequentes.

Oceanos aquecidos aqueceram a atmosfera, tornando o clima global mais quente que o dos 30 anos anteriores.

Porém, em 1988, James E. Hansen, ex-diretor do Goddard Institute for Space Science [GISS/NASA/USA], testemunhou perante o Congresso Americano afirmando que o aquecimento global observado nos últimos anos havia sido provocado pelas emissões de CO2 devido à queima de combustíveis fósseis [carvão mineral, petróleo e gás natural] em decorrência das atividades humanas.

Nesse mesmo ano, foi criado o Painel Intergovernamental de Mudanças Climáticas [sigla em Inglês, IPCC] e a histeria do aquecimento global antropogênico [AGA] se alastrou globalmente.

Na realidade, esse movimento teve sua origem em 1972 com a Conferência das Nações Unidas para o Meio Ambiente, conhecida como Conferência de Estocolmo [Suécia], que não teve muita relevância na mídia por conta do período frio que persistia desde 1946.

Portanto, dessa breve história, é possível concluir que o clima varia por causas naturais e que períodos quentes são benéficos, enquanto períodos frios são ruins para a Humanidade.

2. O Efeito Estufa

O IPCC foi criado com o fim específico de demonstrar que as atividades humanas exercem influência significativa no clima global e não para determinar, com transparência, as causas físicas naturais do aquecimento entre 1976-2005.

Ou seja, o órgão já nasceu com um viés severo.

|

| A irracionalidade do aquecimento global induzido pelo homem leva a absurdos |

O pilar principal da teoria do AGA é o efeito-estufa.

Pela definição utilizada pelo IPCC, o efeito-estufa se assemelha ao processo que acontece numa estufa de plantas [casa de vegetação].

Os painéis de vidro da estufa permitem a passagem da radiação solar, que é composta de radiação ultravioleta [UV], radiação visível aos nossos olhos [VIS] e da radiação infravermelha [IV], de pequeno comprimento de onda [até 4 micrômetros].

A radiação solar aquece as superfícies internas da estufa e estas aquecem o ar e emitem IV térmica.

O vidro é opaco à IV térmica e aprisiona comprimentos de onda superiores a 3 micrômetros dentro da estufa.

Muitos acreditavam que esse processo era responsável pela temperatura do ar dentro da estufa ser mais elevada que a temperatura do ar fora da estufa.

Como já se sabia que as temperaturas do ar próximas à superfície terrestre são mais elevadas que as que encontram em níveis mais altos da atmosfera, passaram a fazer analogia com o que ocorria na estufa, após o pesquisador britânico John Tyndall, em 1859, ter descoberto que gases como vapor d’água [H2O], dióxido de carbono [CO2] e metano [CH4] absorvem IV térmica.

Ou seja, a superfície terrestre, aquecida pela radiação solar, emite IV térmica que é absorvida pelos constituintes minoritários da atmosfera, como CO2 e CH4, os chamados gases de efeito-estufa [GEE].

Estes reemitiriam IV térmica em todas as direções, inclusive de volta para a superfície e reduziriam a perda de IV térmica para o espaço exterior.

Os GEE, principalmente o CO2, atuariam como os painéis de vidro da casa de vegetação, “aprisionando” a IV térmica.

Essa seria a explicação para manter a temperatura do ar próximo à superfície terrestre mais elevada que nas camadas mais altas da atmosfera.

E a conclusão óbvia que vem dessa definição é que, se as concentrações do CO2 — por meio da queima de combustíveis fósseis — e as de metano — por meio do aumento do número de cabeças de gado ruminante [e.g. vaca, ovelha, cabra] — aumentarem, mais IV térmica é absorvida pelos GEE, menos IV escapa para o espaço exterior, e o clima do Planeta se aquece!

Essa definição de efeito-estufa é altamente questionável e isso pode ser demonstrado por, pelo menos, quatro argumentos.

1º) Robert W. Wood, em 1909 [111 anos atrás], provou que a temperatura do ar dentro da casa de vegetação não dependia do aprisionamento da IV térmica emitida por sua superfície e paredes internas.

Construiu dois modelos de estufa, uma com cobertura de vidro e outra com cobertura de sal de rocha [halita = rock salt]. Contrariamente ao vidro, halita é transparente à radiação IV térmica.

Expôs os dois modelos ao Sol, medindo suas temperaturas internas, e concluiu que as temperaturas finais das duas estufas foram praticamente iguais, com uma pequena diferença de cerca de 1°C entre elas.

Sua conclusão foi que a temperatura do ar dentro da estufa era maior que a do ar fora da estufa não por conta do aprisionamento da IV térmica pela cobertura de vidro, mas porque o ar estava confinado dentro da estufa.

Na atmosfera livre, quando o ar é aquecido, ele se torna menos denso, adquire flutuabilidade e sobe [convecção = transporte de calor por transporte de massa], sendo reposto por ar mais frio vindo das redondezas e/ou de camadas atmosféricas superiores.

Portanto, não se pode comparar o efeito da casa de vegetação com o que ocorre na atmosfera terrestre.

|

| Alarmismos demagógicos com base em sofismas inconsistentes |

2º) Ocorreu um aquecimento global entre 1916 e 1945, observado e bem documentado, e não é possível usar a definição de efeito-estufa do IPCC para explicar esse aquecimento, pois a concentração e as emissões humanas de CO2 eram pequenas naquela época quando comparadas com as atuais.

As temperaturas da década de 1930 ainda são as mais elevadas já registradas nos últimos 130 anos no Hemisfério Norte e na Austrália.

É bem mais provável, como foi dito, que o aquecimento de 1916-1945 tenha sido natural, causado pelo aumento da atividade solar e redução da cobertura de nuvens.

Topos de nuvens refletem radiação solar de volta para o espaço exterior.

Quando a cobertura de nuvens é reduzida globalmente, como ocorreu entre 1976 e 2000 de acordo com os resultados do ISCCP, entra mais radiação solar no sistema climático e o Planeta se aquece.

Torna-se, também, difícil explicar o resfriamento ocorrido entre 1946-1975, pois as emissões de CO2 e sua concentração aumentaram pós-guerra devido à expansão industrial.

3º) A lei de Beer-Bouguer-Lambert afirma que a absorção de radiação por um gás diminui logaritmicamente com aumento de sua concentração.

Esse conhecimento científico é de maneira conveniente ignorado pelos IPCC e apoiadores do AGA.

Com a atual concentração de 400 partes por milhão por volume [ppmv], o CO2 já absorve 87% da IV térmica em sua principal linha espectral ou banda de absorção centrada no comprimento de onda 15 micrômetros.

Ou seja, a contribuição restante na absorção de IV térmica por essa banda seria de, no máximo, 13% mesmo se a concentração de CO2 passar dos 1200 ppmv, o pior dos cenários futuros de concentração de GEE produzidos pelo IPCC, o RCP 8.5 [Representative Concentration Pathway 8.5], que muitos concordam ser impossível de ser atingido com a atual taxa de crescimento de sua concentração.

Em 2013, Murry L. Salby estimou que, aumentando as emissões de CO2, digamos para 1.000 ppmv, i.e. 2,5 vezes a atual, o efeito na temperatura global seria de apenas 0,14°C.

|

| O prof. Molion em palestra |

A média do aumento da temperatura estimados por alguns outros pesquisadores, como Richard Lindzen, Ian Plimer, Robert Carter, Timothy Ball e David Archibald, não passa de 0,5°C.

Uma analogia para se entender a redução da absorção da radiação IV térmica com o aumento da concentração de CO2 seria a pintura de uma janela de vidro com sucessivas demãos de tinta branca.

Após a aplicação da primeira demão de tinta, o vidro ainda permite a passagem da luz.

Uma nova demão sobre a primeira reduz ainda mais a passagem da luz e, assim, sucessivamente até que o vidro fique opaco e demãos de tinta adicionais não terão efeito algum, pois o vidro já não permite a passagem da luz.

Finalmente, é a explicação que a Mecânica Quântica apresenta com relação à absorção de IV térmica pelo CO2.

A atmosfera terrestre é composta de Nitrogênio [N2 = 78%], Oxigênio [O2 = 21%] e Argônio [Ar = 0,9%, um gás nobre], esses três gases constituem 99,9% do ar, enquanto o CO2 apenas 0,04%.

Existem, portanto, cerca de 2.500 moléculas desses gases para cada molécula de CO2.

A molécula de CO2 é poliatômica [mais de 2 átomos] e sem polaridade.

Ela absorve radiação IV por meio de sua rotação ou por vibração de seus átomos.

Ao absorver um quantum de radiação IV térmica, a molécula de CO2 passa de seu estado básico para um estado energético mais elevado, vibra/roda e se choca com algumas das 2.500 moléculas a sua volta, transferindo a energia IV absorvida por meio da colisão e retornando ao seu estado básico.

A Mecânica Quântica afirma que colisões inelásticas são 10 mil vezes mais eficientes para trazer a molécula de CO2 de volta a seu estado básico do que sua emissão de IV.

Portanto, se a molécula de CO2 normalmente perde a energia absorvida por meio de colisões, ela não pode emitir radiação IV térmica e aquecer a superfície terrestre como explica a teoria do AGA defendida pelo IPCC.

Não há dúvida de que o CO2 aquece a atmosfera.

Mas, a sua concentração atual é tão minúscula, muito pouca massa, 400 ppmv [= 0,04%], que é impossível medir sua contribuição para o aquecimento do ar.

É o ar [mistura gasosa, principalmente N2 + O2 + Ar] que se aquece como um todo e irradia IV térmica em direção à superfície terrestre.

|

| O berreiro aquecimentista é tolo e improdutivo |

Como dito acima, se a concentração de CO2 dobrar até o final deste século como apregoa o IPCC [cenário RCP8.5], ainda assim seu efeito será insignificante.

Em outras palavras, na hipótese [ridícula] de se retirar todo CO2 da atmosfera, as temperaturas do ar na superfície terrestre seriam semelhantes às de hoje.

Em adição, CO2 não é um gás tóxico ou venenoso, CO2 é o gás da vida.

Plantas fazem fotossíntese com CO2 e, com concentrações abaixo de 200 ppmv, a maioria das plantas não conseguem fazer a fotossíntese e morrem e, com elas o ser humano e os animais.

Portanto, quanto maior for a concentração de CO2, maior será o benefício para a Terra e seus habitantes.

A frase ouvida com frequência da boca de políticos, burocratas e pretensos ambientalistas “temos de reduzir as emissões de CO2 para evitar que o mundo se aqueça acima de 2°C até o ano 2030”, não faz sentido algum.

O “limite de 2°C” foi inventado por Hans “John” Schellenhuber, diretor do Instituto de Impactos Climáticos [IPK], Potsdam, Alemanha, sem comprovação científica alguma.

Tirou esse valor da “cartola”! Conforme comentado acima, o clima global já esteve mais aquecido que isso no passado e nada de catastrófico aconteceu.

Lamentavelmente, esse mesmo pesquisador foi o assessor do Papa Francisco para assuntos de clima na elaboração da Encíclica Laudato Si, que contém vários parágrafos com afirmações que o homem está aquecendo o mundo com suas emissões de CO2, resultando em aumento do nível dos mares, degelo dos polos, aumento de eventos atmosféricos extremos, todas sem comprovação científica [ver Laudato Si, Cap 1 “Clima como bem comum”, itens 23 a 26].

Afirmações semelhantes também são encontradas no Instrumentum Laboris — publicado outubro de 2019 por ocasião do Sínodo da Amazônia — em particular nos itens 9, 16 e 54.

Esses documentos dão mais munição para alarmistas do clima e para ambientalistas doutrinados.

Em resumo, a concentração de CO2 na atmosfera não controla o clima global.

A atmosfera não “cria” energia para aquecer o planeta, ela apenas retarda a perda de IV térmica, emitida pela superfície, para o espaço exterior.

Reduzir as emissões humanas de CO2 seria inútil, pois não teria algum efeito sobre o clima.

A COVID-19 é um exemplo disso.

Houve uma redução significativa das atividades industriais e nos transportes devido à redução de mobilidade das pessoas durante a pandemia que resultou na redução das emissões e ainda não se vê impacto algum na concentração de CO2.

Concomitantemente, protocolos que visam a redução de emissões humanas de CO2, como o Protocolo de Kyoto [1997] e o Acordo Climático de Paris [2015] não surtirão efeito algum, pois o CO2 não controla o clima global.

Logo após a promulgação do Acordo, Bjorn Lomborg afirmou que se todas contribuições nacionais prometidas forem cumpridas fielmente até 2030, e continuarem a mantê-las por mais 70 anos depois de 2030, a redução total na temperatura global obtida pelo Acordo de Paris será de 0,17°C em 2100.

Por outro lado, os combustíveis fósseis [petróleo, carvão mineral, gás natural] são responsáveis por 85% da geração de energia elétrica mundial.

Reduzir as emissões humanas de CO2 significa gerar menos energia elétrica e obstruir o desenvolvimento de países subdesenvolvidos, aumentado a miséria e a desigualdade social no mundo.

Mas Pachauri acabou preso por fraudes econômicos

e Al Gore fez livro proibido pelos enganos nele contidos

3. Previsões Climáticas pelo IPCC

No Sumário para Formuladores de Políticas [p. 20 SPM, 2013], o IPCC afirma que o aumento da temperatura global média [TGM] para o período 2016-2035, relativo ao período 1986-2005, provavelmente será entre 0,3°C e 0,7°C, e que o aumento para o período 2081-2100, resultante das simulações por Modelos de Clima global [MCG], está projetado para ser provavelmente entre 0,3°C e 1,7°C [RCP 2.6], 1,1°C e 2,6°C [RCP 4.5], 1,4°C e 3,1°C [RCP 6.0] e 2,6°C e 4,8°C [RCP 8.5].

São essas “projeções” por MCG confiáveis? Caberá ao leitor decidir após de ler o que se segue.

Um MCG é um código de computador, muito complexo, com milhares de linhas de instrução, e que depende de um supercomputador para resolver uma dada hipótese de trabalho, ou teste de sensibilidade, no caso, o impacto do aumento da concentração de CO2 na TGM.

O computador, porém, não tem noção do “continuum”.

Os dados de entrada para o MCG têm de ser discretizados.

Ou seja, a assimilação de dados num MCG é feita em pontos de grade, tanto na horizontal quanto em altitude (grade tridimensional), conforme mostrado na figura a seguir.

Os melhores MCG têm uma resolução espacial entre pontos de grade, isto é, um espaçamento horizontal, de 1° de latitude por 1° de longitude, que representa 110 km x 110 km nos trópicos, e é integrado com uma resolução temporal de 30 minutos.

Os dados das variáveis meteorológicas [temperatura, umidade, vento etc…], para o início da simulação, são informados ao MCG em cada ponto de grade distante, em sua maior parte, 110km um do outro.

Isso significa que o MCG não tem “informação”, ou dados observados, sobre o que acontece entre um ponto de grade e outro.

Utiliza-se, então, a “parametrização” da fenomenologia, que é um método de simulação de processos físicos que têm escala muito pequena, ou são muito complexos para serem representados por processo físico simplificado no modelo.

Ou seja, todos os processos físicos de escala espacial inferior à distância entre os pontos de grade [processos sub-grade], como ciclo hidrológico [formação e tipos de nuvens, chuva, taxa de precipitação], vegetação [albedo, evapotranspiração e emissão de CO2], propriedades dos solos, topografia, precisam ser “parametrizados”.

Um exemplo seria uma nuvem cumulonimbus de 30 km de diâmetro equivalente e 12 km da altura situada entre dois pontos de grade — que pode produzir um volume de chuva superior a 50mm e rajadas de vento superiores a 50 km/h localmente — não seria simulada pelo modelo, uma vez que este não tem a informação da presença dessa nuvem.

Criam-se, então, algoritmos matemáticos simplificados, empíricos ou baseados em observações, na tentativa de reproduzir os processos físicos reais.

Portanto, as equações paramétricas utilizadas nos códigos dos MCG são apenas aproximações dos processos físicos reais que ocorrem no sistema climático.

Algumas delas podem ser bem representativas, outras, porém, podem ser grosseiras, pois os processos físicos que elas representam ou não são bem entendidos ou são muito complexos para serem incluídos no código devido às restrições computacionais.

Dentre as parametrizações, o de formação de nuvens e chuva [ciclo hidrológico] merece destaque, pois permanece sendo um dos mais importantes, senão o maior desafio, responsável pela grande diferença de resultados entre MCG.

E, de acordo com o Teorema da Amostragem de Nyquist, a distância entre os pontos de grade é um filtro para processos físicos inferiores a duas vezes a distância entre os pontos de grade.

Na região tropical, todos os processos físicos com escala espacial inferior a 220 km são filtrados, não “percebidos” pelos MCG.

Em adição, essas parametrizações precisam de ser “calibradas”, ou “sintonizadas”, para que os resultados do modelo se aproximem da realidade observada.

Nesse aspecto, existem dois pontos dignos de nota.

Primeiro, a maior parte dos MCG foi “calibrada” com dados observados entre 1975 a 2000, um período em que, reconhecidamente, o clima global esteve aquecido.

Portanto, essa prática é tendenciosa, uma vez que “sintoniza” os MCG na fase quente da variabilidade interna natural do sistema climático e faz que os MCG sejam exageradamente sensíveis às variações de CO2.

O segundo ponto é que os MCG foram desenhados especificamente para responder ao aumento da concentração de CO2 na atmosfera, tanto assim que, de acordo com os relatórios do IPCC, se se mantém a concentração de CO2 fixa, os MCG não apresentam aquecimento global significativo, alguns até apresentam resfriamento.

Ainda mais, os cenários de concentrações de CO2 futuras [RCP] são fictícios, criados pela mente humana, e alguns deles impossíveis de se realizarem, como é o caso do RCP8.5 que prevê uma concentração de CO2 três vezes maior que a atual para 2100.

A discussão, que aqui se encerra, foi simplificada, restrita e não esgota, de maneira alguma, os problemas e dificuldades que se encontram na modelagem do tempo atmosférico e do clima.

Em resumo, existe um debate acirrado na comunidade científica quanto à fidelidade dos resultados dos MCG nos testes de sensibilidade e quanto à sua utilidade em prognosticar climas futuros.

Os resultados de simulação do clima futuro parecem ser altamente questionáveis e, portanto, não são apropriados e recomendados para servir de base para a formulação de políticas públicas que visem o desenvolvimento socioeconômico global em equilíbrio com o meio ambiente.

4. Clima das próximas duas décadas

Refrescando a memória, o IPCC afirmou [p.20 SPM, 2013] que a temperatura global média [TGM], se é que existe uma, muito provavelmente aumentará entre 0,3°C e 0,7°C no período 2016-2035, relativo ao período 1986-2005.

Existem controladores climáticos de prazo longo, de milhares de anos, como, por exemplo, os parâmetros orbitais do Planeta Terra [Ciclos de Milankovitch].

Não se têm condições de avaliar ou quantificar o impacto dessas variações de longo prazo na TGM atual por se processarem lentamente e serem mascaradas por variações decorrentes de fenômenos de escala de tempo rápida e, por vezes, imprevisíveis, como é o caso de eventos de impacto global como El Niño e de grandes erupções vulcânicas.

Aqui exploraram-se os principais controladores do clima global de prazo relativamente curto, décadas, razoavelmente “bem-comportados”, que são o fluxo de radiação solar que é absorvido pelo Planeta, a cobertura de nuvens global e a temperatura da superfície dos oceanos.

Contrariamente às previsões do IPCC, esses controladores estão indicando que a tendência do clima nos próximos 10–12 anos — e há quem diga, para os próximos 22–24 anos — é de ligeiro resfriamento global, e não de aquecimento, um resfriamento semelhante ao do período 1946-1975, resultante de uma frequência maior de invernos mais rigorosos.

A intensidade da atividade solar apresenta ciclos de intervalos de tempo variados, dos quais nos interessa particularmente o Ciclo de Manchas Solares – que dura cerca de 11 anos e cuja numeração teve início em 1749 [Ciclo 1] – e o Ciclo de Gleissberg, da ordem de 100 anos.

No Ciclo de 11 anos, o número de manchas — que é uma medida da atividade solar — começa praticamente com zero manchas, atinge um máximo em cerca de quatro anos e decresce novamente para zero nos sete anos subsequentes.

Tanto no início quanto no final de um Ciclo de Gleissberg [100 anos], ocorrem dois a três Ciclos de Manchas de 11 anos com média mensal máxima de manchas relativamente baixa.

|

| A desaparição das manchas na superfície solar é sinal típico do 'Mínimo Solar' |

Esse período foi chamado de “Mínimo de Dalton” e foi um período frio.

No início do século XX, ocorreu outro mínimo do Ciclo de Gleissberg, também um período frio, e seu máximo ocorreu no Ciclo 18 de manchas [1957], com média mensal máxima de 269 manchas.

A partir de 1957, os máximos de manchas em cada Ciclo de 11 anos começaram a diminuir, indicando que a atividade solar estava se reduzindo.

Neste ano de 2020, começa o Ciclo 25 de manchas, que inaugura um novo mínimo do Ciclo de Gleissberg, e os físicos solares preveem que o Ciclo 25 [2020 a 2030], e possivelmente o Ciclo 26 [2031 a 2042], apresentarão atividade inferior ao Mínimo de Dalton, ocorrido há 200 anos.

Sabe-se que a baixa atividade solar enfraquece o campo magnético solar que protege os planetas da “chuva” de raios cósmicos galácticos [RCG] provenientes de explosões de estrelas supernovas.

O campo magnético solar enfraquecido permite o aumento do fluxo de RCG que entra na atmosfera terrestre que, por sua vez, provoca um aumento da cobertura de nuvens globalmente, de acordo com a teoria do físico dinamarquês Henrik Svensmark.

Esse aumento resultará em uma redução da entrada do fluxo de radiação solar no planeta que resfriará os oceanos e, estes, o clima global.

Ou seja, os principais controladores do clima global na escala temporal de décadas estão apontando para um resfriamento global entre 2020 e 2040 e não um aquecimento como prevê o IPCC.

Em resumo, é muita pretensão do homem querer modificar o clima global com suas emissões de CO2, que são inferiores a 5% das emissões naturais provenientes dos oceanos, vegetação, solos e vulcões.

As previsões de aumento da temperatura média global [entre 1,7°C e 4,8°C para 2100] publicadas pelo IPCC são elaboradas com modelos de clima global [MCG] que apresentam sérias limitações, não conseguindo replicar o clima passado observado, e são alvo de críticas severas por parte da comunidade científica com relação à confiabilidade de suas projeções climáticas.

Tais projeções são fictícias, meros exercícios acadêmicos que não se prestam para formulação de políticas públicas de desenvolvimento socioeconômico em harmonia como o meio ambiente.

O CO2 não controla o clima global! Reduzir as emissões antrópicas não terá efeito algum sobre o clima e protocolos, como os de Kyoto [1997] e o Acordo Climático de Paris [2015] que são inúteis.

Mas, caso seja tentada, além de gastar trilhões de dólares, a redução das emissões trará grandes malefícios para a Humanidade.

Primeiro, porque 85% da energia elétrica gerada globalmente depende dos combustíveis ditos fósseis.

Reduzir emissões implica em gerar menos energia elétrica e isso afetará mais severamente os países em desenvolvimento, aumentando as desigualdades sociais no mundo.

Convém lembrar que as energias renováveis dependem das condições atmosféricas que, se não são favoráveis, não há geração.

Em palavras simples, se não houver vento, os aerogeradores não geram, se não houver radiação solar, os sistemas solares [painéis e concentradores solares] não geram e assim por diante.

Todas as plantas de energias renováveis, portanto, precisam de uma termelétrica que usa combustível fóssil para manter o fornecimento de energia elétrica seguro [backup].

Segundo, porque vegetação faz fotossíntese com CO2, e a redução de sua concentração traria uma diminuição de sua produtividade num mundo que, estima-se, daqui a 20 anos terá uma população de nove bilhões de seres humanos a serem alimentados.

As palavras de Francis Bacon contrariam de forma sucinta a crença das mudanças climáticas produzidas pelo homem: “Natura enim non imperatur, nisi parendi”.

Traduzindo, “Não podemos comandar a Natureza, apenas obedecê-la”.

NOTAS:

Para aqueles que desejam aprofundar mais em suas avalizadas posições sobre o clima, aquecimento global, meteorologia, ecologia, ambientalismo e temas conexos, oferecemos as publicadas em nosso modesto blog, no link: Molion.

Também oferecemos a página Prof. Luiz Carlos Baldicero Molion, da Universidade Federal de Alagoas, com uma coleção de vídeos que temos podido coletar com brilhantes intervenções do Professor.

A continuação apresentamos mais uma intervenção do prof. Molion que também se destaca pela sua oportunidade, sapiência e ponderação científica, difundida pela Agência Boa Imprensa – ABIM, em dezembro de 2020.

Nenhum comentário:

Postar um comentário